Nel panorama dell'intelligenza artificiale moderna, gli embeddings rappresentano una delle tecnologie più potenti e versatili per la comprensione e l'elaborazione del linguaggio naturale. Questa tecnologia, che trasforma testi in rappresentazioni numeriche dense e significative, sta rivoluzionando il modo in cui i sistemi AI comprendono e processano le informazioni testuali.

Cosa sono gli Embeddings?

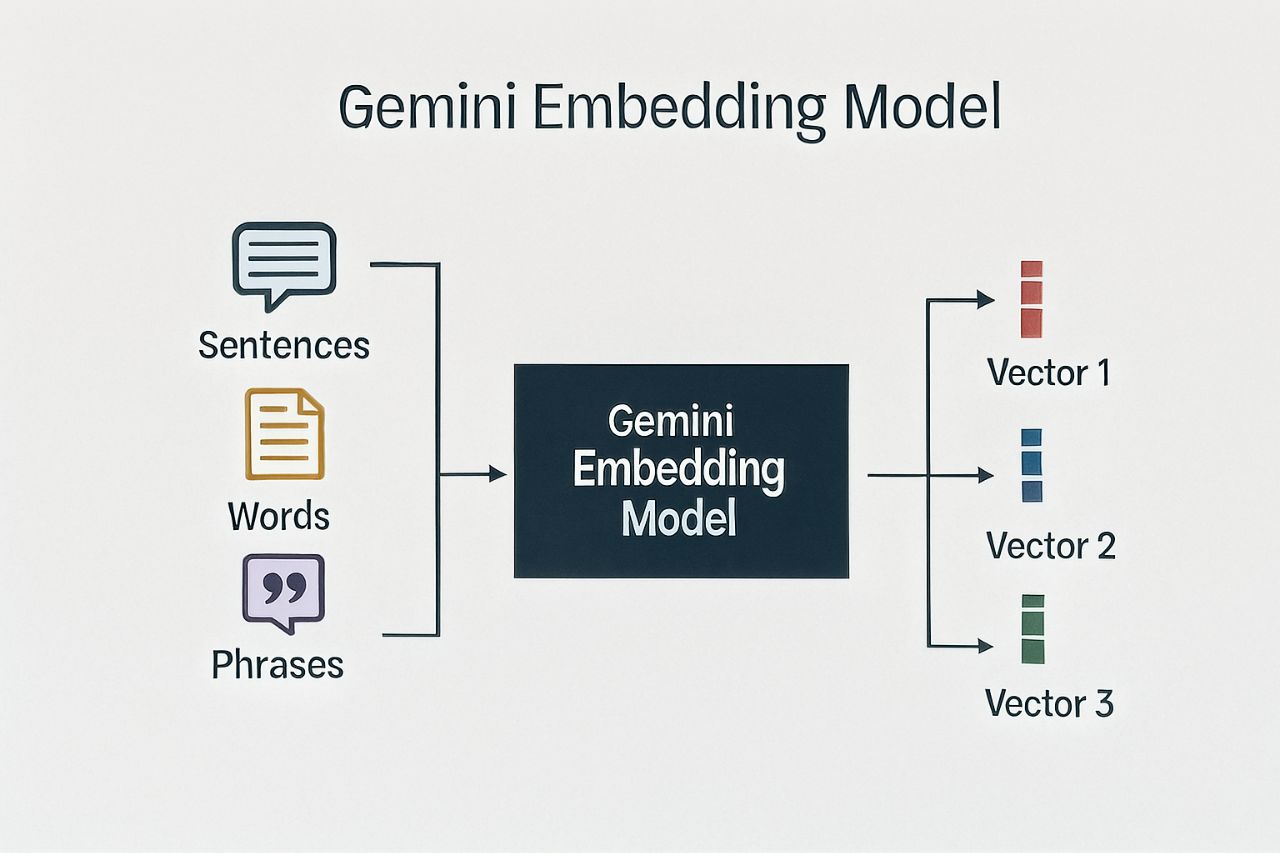

Gli embeddings sono rappresentazioni numeriche di parole, frasi, paragrafi o interi documenti sotto forma di vettori multidimensionali. Questi vettori catturano il significato semantico del testo in uno spazio matematico, dove testi con significati simili sono posizionati vicini tra loro.

Caratteristiche principali degli embeddings:

Densità semantica: A differenza degli approcci tradizionali basati su parole chiave, gli embeddings catturano sfumature di significato, sinonimi e relazioni concettuali complesse.

Dimensionalità fissa: Indipendentemente dalla lunghezza del testo originale, ogni embedding ha sempre la stessa dimensionalità (ad esempio, 768 dimensioni per il modello Gemini).

Confrontabilità: La similarità tra due testi può essere calcolata utilizzando metriche come la similarità del coseno tra i rispettivi embeddings.

Contestualità: Gli embeddings moderni considerano il contesto in cui le parole appaiono, permettendo di distinguere tra diversi significati della stessa parola.

Il Modello Gemini Embedding 001

Google ha sviluppato un modello chiamato gemini-embedding-001, un sistema avanzato per la generazione di embeddings testuali che offre prestazioni superiori in termini di accuratezza e comprensione contestuale.

Vantaggi del modello Gemini:

- Alta qualità semantica: Produce embeddings che catturano efficacemente il significato e le relazioni tra concetti

- Versatilità: Funziona bene su diversi tipi di testo: parole singole, frasi, paragrafi e codice

- Efficienza: Ottimizzato per performance elevate con un buon rapporto qualità/velocità

- Integrazione semplice: API REST facile da utilizzare e integrare in applicazioni esistenti

Cos'è il RAG (Retrieval Augmented Generation)?

Il RAG, o Retrieval Augmented Generation, è un paradigma architetturale che combina le capacità di recupero delle informazioni con la generazione di testo dei modelli linguistici. Questa tecnica permette ai modelli AI di accedere a informazioni esterne e aggiornate durante il processo di generazione delle risposte.

Come funziona il RAG:

1. Indicizzazione: I documenti della knowledge base vengono convertiti in embeddings e memorizzati in un database vettoriale2. Query: Quando l'utente pone una domanda, questa viene convertita in embedding

3. Retrieval: Il sistema cerca i documenti più simili semanticamente nella knowledge base

4. Augmentation: I documenti recuperati vengono aggiunti al prompt come contesto

5. Generation: Il modello linguistico genera una risposta informata dal contesto recuperato

Vantaggi del RAG:

- Accuratezza fattuale migliorata: Le risposte sono basate su informazioni concrete e verificabili dalla knowledge base.

- Aggiornabilità: È possibile aggiornare la knowledge base senza riadddestrare il modello linguistico.

- Trasparenza: È possibile tracciare le fonti utilizzate per generare una risposta.

- Riduzione delle allucinazioni: Il modello ha meno probabilità di inventare informazioni false avendo accesso a dati reali.

- Specializzazione: Permette di creare sistemi esperti in domini specifici senza training aggiuntivo del modello base.

Contesti di Utilizzo del RAG

Il RAG trova applicazione in numerosi scenari dove è necessario combinare la comprensione linguistica avanzata con informazioni specifiche e aggiornate:

Assistenti virtuali aziendali

Creazione di chatbot che possono rispondere a domande specifiche sull'azienda, utilizzando documenti interni, manuali, policy e procedure come knowledge base.

Supporto tecnico e documentazione

Sistemi che aiutano gli utenti a trovare soluzioni ai loro problemi tecnici, attingendo da vasti archivi di documentazione e casi risolti.

Ricerca scientifica e medica

Piattaforme che permettono ai ricercatori di interrogare rapidamente vasti database di pubblicazioni scientifiche per trovare informazioni rilevanti.

Analisi legale

Strumenti che aiutano avvocati e legal professionals a cercare precedenti, interpretazioni di leggi e casi simili in grandi database giuridici.

E-learning personalizzato

Sistemi educativi che possono fornire spiegazioni personalizzate attingendo da materiali didattici specifici per ogni studente.

Implementazione Pratica con Gemini

Ecco come utilizzare il modello gemini-embedding-001 per generare embeddings: Esempio di chiamata API:

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-embedding-001:embedContent" \

-H "x-goog-api-key: $GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-d '{"model": "models/gemini-embedding-001",

"content": {"parts":[{"text": "Che cos'è l'intelligenza artificiale?"}]}

}'

Struttura della risposta:

La risposta conterrà un vettore di numeri floating-point che rappresenta l'embedding del testo fornito. Questo vettore può poi essere utilizzato per:

- Calcolare similarità con altri embeddings

- Memorizzare in un database vettoriale per ricerche semantiche

- Alimentare algoritmi di clustering o classificazione

Best Practices per l'Implementazione

Quando si implementa un sistema basato su embeddings e RAG, la preparazione dei dati rappresenta il primo passo fondamentale. Il preprocessamento del testo richiede particolare attenzione: è essenziale pulire i documenti da caratteri speciali che potrebbero interferire con la qualità degli embeddings, normalizzare la formattazione per garantire coerenza e dividere documenti particolarmente lunghi in sezioni più piccole e gestibili. Questa segmentazione, chiamata "chunking", è cruciale perché permette di mantenere la precisione semantica e migliora l'efficacia del retrieval.

L'ottimizzazione delle performance diventa centrale quando il sistema deve gestire volumi significativi di dati. In questi casi, la Batch API di Gemini rappresenta una soluzione economicamente vantaggiosa, offrendo elaborazioni in volume a costi ridotti. Parallelamente, implementare sistemi di caching per gli embeddings più frequentemente richiesti può ridurre drasticamente i tempi di risposta e i costi operativi. Per applicazioni enterprise, l'adozione di database vettoriali specializzati come Pinecone, Weaviate o Qdrant non è solo consigliata ma spesso necessaria per garantire performance ottimali nella ricerca semantica.

Il monitoraggio continuo della qualità rappresenta un aspetto spesso sottovalutato ma critico per il successo a lungo termine del sistema. È fondamentale testare regolarmente l'accuratezza dei retrieval, implementando metriche quantitative che permettano di valutare oggettivamente la rilevanza dei risultati restituiti. Inoltre, la knowledge base deve essere considerata un organismo vivente che richiede aggiornamenti periodici per mantenere la sua efficacia nel tempo.

Considerazioni Tecniche e Limitazioni

L'aspetto economico e la scalabilità richiedono un'attenta pianificazione strategica. Gli embeddings comportano costi computazionali significativi sia per la generazione che per lo storage, ed è cruciale sviluppare una strategia di ottimizzazione che tenga conto della frequenza con cui si prevede di aggiornare la knowledge base, del volume di query che il sistema dovrà gestire e dei requisiti di latenza specifici dell'applicazione. Un sistema che deve rispondere in tempo reale avrà esigenze molto diverse da uno utilizzato per analisi batch notturne.

La qualità dei dati rappresenta il tallone d'Achille di qualsiasi sistema RAG. Non importa quanto sofisticato sia il modello di embedding o l'architettura del sistema: se la knowledge base contiene informazioni obsolete, incomplete o errate, queste si rifletteranno inevitabilmente nella qualità delle risposte generate. Questo aspetto richiede un investimento costante in processi di curation e validazione dei dati, spesso sottovalutato nella fase di pianificazione dei progetti.

Un aspetto particolarmente delicato riguarda i bias e l'equità del sistema. Gli embeddings, essendo addestrati su grandi corpus di testi, possono perpetuare e amplificare bias presenti nei dati originali. Questo fenomeno può portare a risposte discriminatorie o non inclusive, richiedendo un'attenzione particolare durante la fase di implementazione. È necessario sviluppare strategie di mitigazione che includano audit regolari delle risposte generate, diversificazione delle fonti nella knowledge base e implementazione di filtri per identificare e correggere potenziali bias nelle risposte del sistema.

Conclusioni

Gli embeddings e il RAG rappresentano una combinazione potente per creare sistemi AI più accurati, informativi e utili. Il modello gemini-embedding-001 di Google offre una soluzione robusta e accessibile per implementare queste tecnologie.

L'adozione del RAG permette di superare molte limitazioni dei modelli linguistici tradizionali, offrendo risposte più accurate e contestualizzate. Con l'evoluzione continua di queste tecnologie, possiamo aspettarci applicazioni sempre più sofisticate e utili in numerosi domini.

La chiave del successo nell'implementazione del RAG risiede nella combinazione di una buona architettura tecnica, dati di qualità e un'attenta ottimizzazione del sistema per le specifiche esigenze del caso d'uso.